第5回 AIの品質・安全性・トラストに関するガイドライン・標準

前回までのコラムにおいては、AIシステムならではの品質やトラストの特性について議論してきました。最後に振り返りも兼ねて、関連するガイドラインや標準のいくつかを紹介します。

AIQMガイドライン・QA4AIガイドライン

深層学習技術を用いたAIシステム構築が盛んになると、その品質保証に関する悩みや課題に対する注目が高まってきました。特にこの動きは2018年前後に盛り上がり、国内では「品質」という語に焦点を当てた二つのガイドラインが公開されました。どちらもこれまでのソフトウェアシステムや機械システムなどの品質や安全性に対するアプローチを踏まえた取り組みとなっています。

AIQMガイドラインは、産業技術総合研究所を中心に、産業界のメンバーも加えて策定が行われました。AIQM の QM は、Quality Management を指します。初版は2020年ですが、定期的に更新され、本コラム執筆時には4.2.0版が公開されています。AIQMガイドラインは、国際標準になるようなことも意識して書かれており、概念の定義からしっかりと整理・記載されており、規範が明確に述べられています。

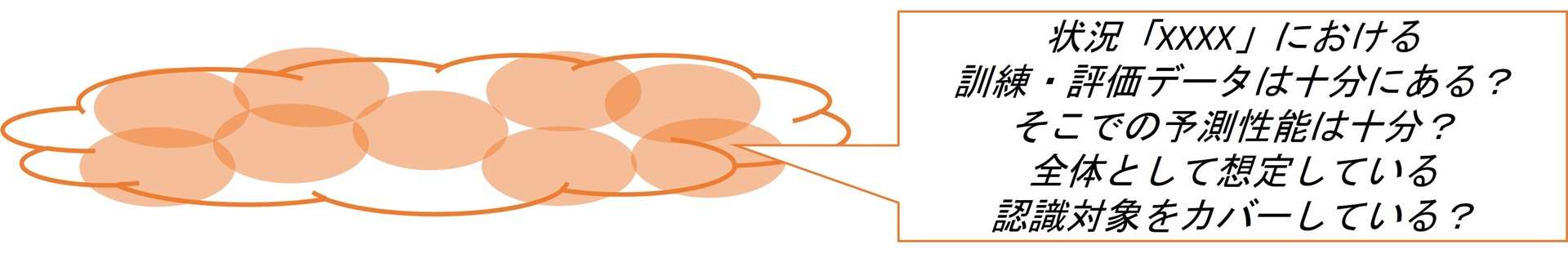

AIQMガイドラインにおいては、本コラム第2回で述べたような、データと予測性能に対する評価の考え方が非常に明確に整理されています。つまり、AIが扱おうとする認識対象を「いろいろな運転シーンにおけるいろいろな障害物」と言ってしまうと品質の定義や評価ができません。このため、実現したい価値や効果、発生しうるリスク、想定する環境や社会の要請などを踏まえて、「都会での霧の状況」など何かしらの「場合分け」を行う形で、問題を分析した上で、データおよびAI(予測モデル)を評価する必要があるということです。

図1:データおよびモデルを評価するための問題分析における「場合分け」のイメージ

問題分析に応じたデータ・モデルの評価

■要求や仮定に関する言葉が本質的にあいまい

- 実世界における本来あいまいなタスクをそのまま表現

- それでも開発活動ではオントロジーの明示化・理解統一が必要!

■データや評価指標と紐付け具体化することが必要不可欠

- 例:「○○タイプの不良品」の画像データは具体的にどれ?

- 特定のデータを識別し、区別して扱うことにより、データの十分性を評価し、AIの訓練や評価に反映する

AIQMガイドラインにおいては、本コラムと同じく、品質特性という概念を使ってAIの品質に対する評価の観点を整理しています。まず予測性能が高くないと、応用上の効果が得られないという「AIパフォーマンス」という特性が挙げられています。しかし、「90%当たる」というだけでは、致命的な事故につながるような誤りが避けられるかという問いに答えられません。このため、「リスク回避性」という特性も考える必要があります。そのほか、本コラムでも論じてきた「公平性」や「セキュリティ」とともに「プライバシー」も機械学習型AIシステム固有の特性として挙げられています。さらに、こういった特性に対して「どこまでしっかり扱うべきか」は、対象システムの位置づけ、例えば誤りが人命に関わるかどうかといったことに依存します。AIQMガイドラインでは、品質特性に対するレベル分けも整理されています。

もう一つの取り組みとして、QA4AIガイドラインがあります。こちらは、従来のソフトウェアシステムに対するテストや品質保証に取り組んできたようなエンジニアや研究者を中心としたボランティア団体(QA4AIコンソーシアム)が公開しています。こちらのガイドラインも定期的に更新されています。

QA4AIガイドラインでは、チェックリスト形式によりAIシステムの品質を考える上での留意点が挙げられています。データや予測モデル、そしてAIシステム全体という開発の成果物だけでなく、開発組織体制やそのプロセスにおける留意点、顧客の期待に関する留意点も挙げられています。AIシステムの開発や運用においては、不確実性が高いため、継続的な監視と改善を効率的に、迅速に実施できるような体制・プロセスが重要となります。また、企画や発注・利用を行う顧客やステークホルダーがAIシステムに求める内容やその強さがまちまちであったり、ときには過度な期待があったりするため、顧客との対話が重要になります。

QA4AIガイドラインでは、一般的な留意点だけでなく、具体的な応用領域ごとのサブガイドラインも提供しています。自動運転、工場での利用など産業用プロセス、スマートスピーカーなどの音声インターフェース、OCR(文字読み取り)、画像・動画などのコンテンツ生成といった領域のサブガイドラインが提供されています。より具体的なテスト・評価事例などが記載されています。

2018 年前後の当時は、本コラムでまとめているような、AI 品質に関する原則や技術も、まだ確立というよりは盛んに議論されている状況で、企業やプロジェクトごとに一から悩まなくて良いようなガイドラインを提供することは喫緊の課題でした。これが二つのガイドラインの公開という流れにつながっています。その後、両者はしっかりと連携し、お互いの立ち位置を確認して活発的に更新を続けています。AIQMガイドラインの方が、概念や規範がしっかりと述べられていますが、抽象度が高く、具体的にとるべき活動内容が想像しづらいかもしれません。QA4AIガイドラインは、やや個別事例に特化した書き方の点もある一方、活動内容の具体例やテスト設計の指針などより踏み込んだ情報を得ることができます。

様々なガイドライン・標準・法

ここまでは、開発者の活動を中心に扱っている比較的具体的な国内二つのガイドラインについて紹介しました。本コラムの執筆時には、これらのガイドラインの初版が出てからすでに約5年経過しています。このため、これらのガイドラインを基にして社内用のチェックリストなどが整備されている企業もあるでしょう。少なくとも、開発者としても、あるいは社会としても、例えばデータ品質の重要性や、公平性への配慮の必要性などはよく知られているので、「対応するのが当たり前」になってきています。

AIの品質やトラストが話題になってから時間が経つにつれ、政府や標準化機関などから、より影響力の大きいガイドラインや標準も発行されています。

国内では2024年4月に、総務省と経済産業省から、AI事業者ガイドラインが発行されています。AIの開発者、提供者、利用者という三つの視点からのガイドラインとなっているほか、近年の生成AIの議論も踏まえているので、AIQM・QA4AI両ガイドラインよりも広い範囲の議論となっており、例えば、教育とリテラシーについてまで言及があります。ただし、記述としては抽象度が高いもので、具体的なAIプロダクト・サービスを考える際には、やはりAIQM・QA4AI両ガイドラインで提示されているような実現レベルのチェックリストを見ていく必要があるでしょう。

海外を見ても、アメリカNIST(National Institute of Standards and Technology)によるAIリスクマネジメントフレームワーク(リンク先はAISIによる和訳)、欧州における倫理ガイドライン(2019年)からAI Act(2024年承認)までの一連の流れ、中国における規制など話題は尽きません。さらには、ISOなどにおける標準も、例えば一部だけ挙げるにしても以下のようなものがあります。

- ソフトウェア工学分野での標準、例えば本コラムのように品質特性を定義したISO 25059:2023 SQuaRE for AI

- AI分野での標準、例えばリスクマネジメントを論じているISO/IEC 23894:2023

- 自動車など個別分野での標準、例えば自動運転や高度運転支援などにおいて機械学習技術を用いる際の安全性やリスク要因を論じたISO 8800(本コラム執筆時では承認段階を表すDPAS)

非常に多様なコミュニティ・観点からたくさんのガイドラインや標準が出ています。基本的には2020年前後にはある程度共通認識として確立した考え方に基づいたものなので、「AIQM・QA4AIガイドラインに対してしっかりやってきたが全然足りない」といったことにはならないでしょう。そういった共通の原則や技術も踏まえつつ、「自動車」や「医療」など対象とする領域・コミュニティで見るべきとされるガイドラインや標準についてしっかり確認し、取り込んでいくことになるでしょう。

ただし、欧州のAI Actについては、特定種類のAIなどについて、指針ではなく「禁止」としていることがあるため、AI Actについてはより踏み込んだ留意が必要となります。例えば、人間に対して社会スコアを付ける、不特定多数の顔画像からデータベースを作る、リアルタイムの生体情報収集を逮捕のような法執行に用いるといったことが禁止されています。また、チャットしている相手が人間ではなくAIである場合は明示するといった約束事もあります。

まとめ

今回までのコラムでは、機械学習技術、特に深層学習技術から登場して発展してきたAIシステムにおける品質・トラストの特性について論じてきました。2022年後半のChatGPTが登場以降、大規模言語モデルと呼ばれる技術を用いたAIシステムの品質・トラストも盛んに議論されるようになっています。次回からは、この動向について紹介していきます。

これまでのコラム

第1回 機械学習技術によるAIの産業における活用

第2回 AIシステムにおける予測性能とデータ品質

第3回 AIシステムにおける広義の品質・トラスト (1)

第4回 AIシステムにおける広義の品質・トラスト (2)

筆者紹介 石川 冬樹(いしかわ ふゆき)

石川 冬樹 国立情報学研究所 アーキテクチャ科学研究系 准教授

筆者紹介の詳細は、第1回をご参照ください。