近年の AI(Artificial Intelligence、人工知能)技術への関心の高まりと相まって、その利用による社会的リスクについても関心が高まり、そのガバナンスの必要性が指摘されています。

計 10 回にわたる本コラムでは、このような AI 技術による社会的リスクとそのガバナンスを巡る全体像について俯瞰していきます。

本連載の筆者は、市川類 東京科学大学 データサイエンス・AI全学教育機構 特任教授 / 一橋大学 イノベーション研究センター 特任教授 です。

©2024 Tagui Ichikawa(本コンテンツの著作権は、市川 類 様に帰属します)

第2回 社会規範・倫理と技術による社会的リスク

前回のコラムでは、技術のイノベーションに伴って生じる「社会的リスク」の低減・管理のためには、そのガバナンスに係る取り組みが必要なことをお話しました。

今回のコラムでは、社会的リスクは、技術のイノベーションに伴ってどのように生じるのかについて、「社会規範・倫理」という観点からお話します。

(1) 人類と社会規範・倫理

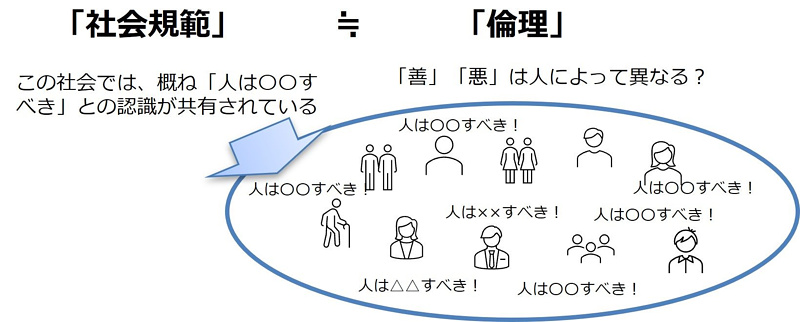

一般的に、人類は、社会的な存在であり、社会生活にあたって集団としての価値観(行動 規範)を共有しています。本コラムでは、これを「社会規範」と呼びます。この社会規範は、社会的動物である人類が、生物的(遺伝的)あるいは文化的に進化する中で、種として生存・繁殖する中で形成されてきたものと位置づけられます。人々は、自らの DNA に組み込まれた生存・繁殖への欲求に加えて、個々の人々が内面から感じる「倫理」に従って善や悪を評価し、行動していますが、この社会規範は、これらの人々の感じる「倫理」の集合体的な位置づけと理解することができます(図4参照)。

このような人類の価値観としての社会規範は、現代では、概ね世界全体として共有されており、具体的には、人命の尊重、環境の保護などに加えて、プライバシーの保護を含む基本的人権の尊重や、民主主義の実現などがあげられます。しかしながら、この社会規範は、その時代やそれを取り巻く社会・技術環境に従って変化するともに、地域ごとによって文化的な差異も存在することに留意することが必要です。

その上で、人々は、この社会規範(価値感)に抵触するような行為等は、社会的に「悪」であるとみなし、その行為等を制限するために必要な社会的な取り組みや制裁などのルールを整備していくことになります。

なお、上述のとおり、人間は、自らの生存・繁栄などの欲求を踏まえつつも、このような社会規範の下で、自ら意思・目的をもって行動する主体ですが、この点こそが、外部から一定の目的のためにプログラミングされた機械(AI)とは全く異なる特徴であり、人間と AIの共存する社会の実現にあたって重要な論点になることが指摘されています。

図4:倫理と社会規範の関係

<現代の世界の社会規範>

・人類の社会規範は、概ね国際的に共通。

– 生命・身体の保護(安全性)・環境の保護、財産権の保障、基本的人権の保護、民主主義 など

– 例:国連人権条約などにおける規定

・但し、地域文化による差異、時代(技術進展)によって変化。

– 宗教による差異(例:人工中絶技術など)

– 時代による変化(例:「公平性」の範囲など)

(2) 社会的リスク:新技術の利用による社会規範への抵触

このような中、人間は、その文明的な進化の過程において、知性を発達させ、新たな技術を獲得してきました。この技術は、前述のとおり、それを利用することによって、人間の能力を拡充することが可能になるものであり、その結果、人類に対して社会的な便益をもたらしてきました。

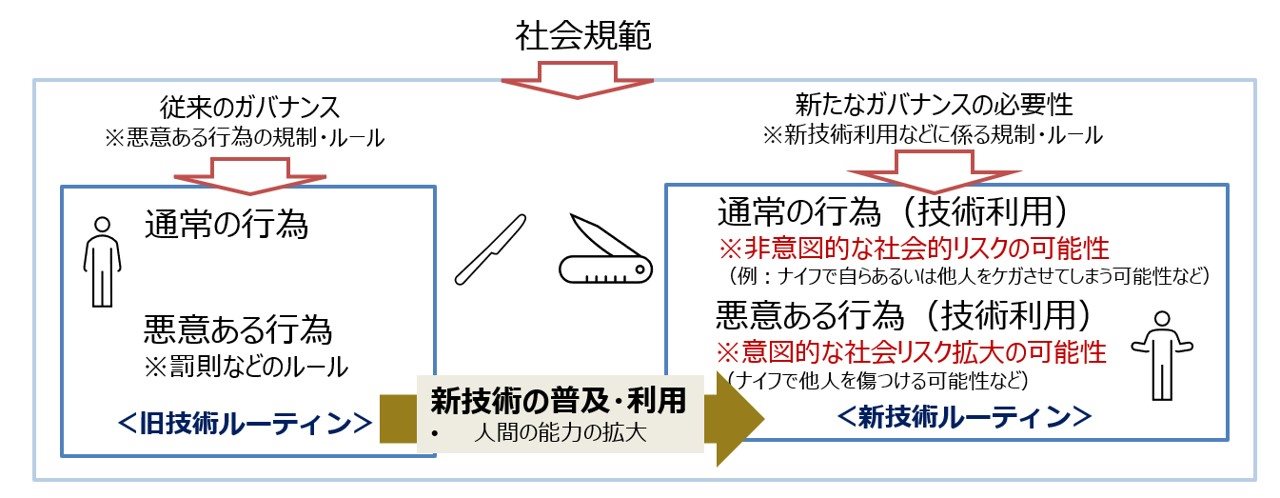

しかしながら、新たな技術は、その能力がゆえに、その利用方法によっては、これまでの技術では想定しえなかったような「社会規範への抵触」、すなわち、社会の共有する価値観から見て人々が「悪」と判断するような場合が生じることがあります。

例えば、ナイフの事例を考えてみましょう。石器・金属器、そしてナイフの発展は、人類に対して、「モノを切る」という能力を人類に与えることになり、その結果、人類の発展に大きな寄与をしてきたことは、言うまでもありません。しかしながら、ナイフが有するその能力がゆえに、社会規範に抵触するような利用方法が行われる可能性があります(図5参 照)。本コラムでは、このような技術の利用による社会規範の抵触の可能性を、技術による「社会的リスク」と呼ぶこととします。

図5:技術による社会規範への抵触

(3) 社会的リスクのパターン:社会的、倫理的、法的な課題としての顕在化

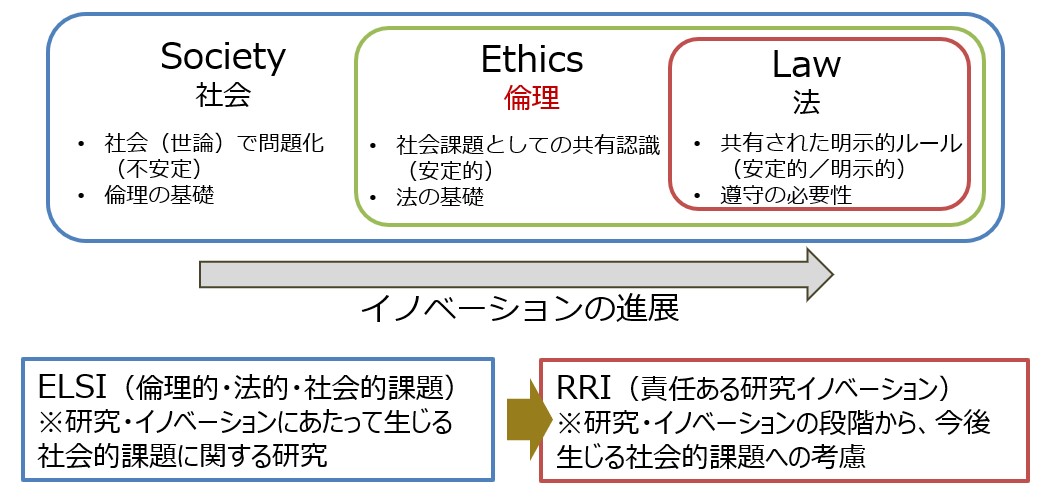

技術による社会的リスクは、一般的に、その技術のイノベーションの進展に伴って、そのリスクが社会的に顕在化し、社会問題化(Social)する中で、一部は倫理(Ethics)に反するものと社会全体として認識され、そのうち一部は、法令(Legal)におけるルール整備が検討されるという順序関係にあります(図6参照)。

このような3段階に関し、近年、ELSI(エルシー)という言葉に関心が高まってきています。この ELSI とは、倫理的・法的・社会的課題(Ethical, Legal and Social Issues)のことであり、新規科学技術を研究開発し、社会実装する際に生じうる、技術的課題以外のあらゆる課題(リスク)を指すものです。

このような ELSI への関心の高まりの背景には、生命科学に加え、特にデジタル・AI 技術などの新興技術の重要性の増大があります。すなわち、従来、社会を主導してきた製造・エネルギー関係の技術の多くは、安全・環境に係る社会的リスクを引き起こしましたが、それらのリスクに対しては、長年にわたり議論がなされ、概念化、法整備がなされてきたという歴史があります。これに対し、デジタル・AI のような新たな技術の多くは、プライバシー、公平性などの人権に係る社会的リスクを多く引き起こす可能性があります。このため、このような新たな社会的リスクに対しては、社会としてまだ十分に議論されておらず、社会としての受容基準も明確にされていないのが現状です。また、これらの新興技術に係る社会的リスクは、このように概念化や法整備が追い付いていないことから、「倫理問題」として扱われることが多くなります。

なお、この ELSI については、科学技術の研究やイノベーションの過程において付随的に発生する課題としてしか扱っていないとの批判があり、これに対して、近年は、むしろ、研究開発・イノベーションの段階からこれらの社会的リスクへの対応に積極的に取り組むべきとの観点から、「責任ある研究・イノベーション」(Responsible Research and Innovation)という概念が重要視されています。AI に関しても、単に「AI 倫理」として取り組むのではなく、「責任ある AI(Responsible AI)」という視点で、研究開発・イノベーションの段階から取り組むことが必要であると指摘されてきています。

図6:技術による社会的リスクのパターン

これまでのコラム

筆者紹介 市川 類(いちかわ たぐい)

東京科学大学 データサイエンス・AI全学教育機構 特任教授

一橋大学 イノベーション研究センター 特任教授

筆者紹介の詳細は、第1回をご参照ください。