近年の AI(Artificial Intelligence、人工知能)技術への関心の高まりと相まって、その利用による社会的リスクについても関心が高まり、そのガバナンスの必要性が指摘されています。

計 10 回にわたる本コラムでは、このような AI 技術による社会的リスクとそのガバナンスを巡る全体像について俯瞰していきます。

本連載の筆者は、市川類 東京科学大学 データサイエンス・AI全学教育機構 特任教授 / 一橋大学 イノベーション研究センター 特任教授 です。

©2024 Tagui Ichikawa(本コンテンツの著作権は、市川 類 様に帰属します)

第5回 信頼性・安全性に係る社会的リスク

前回のコラムにおいては、AI 技術がもたらす社会的リスクの全体像についてのお話をしました。

今回のコラムにおいては、まずはその具体的リスクとして、AI システムに係る信頼性・安全性に係る社会的リスクの概観についてお話をします。

(1) 工学システムの信頼性と情報システムのセキュリティ

もともと、工学・機械系のシステムにおいては、設計・意図された機能を果たすべく、信 頼性を確保するとともに、その中でも、とりわけ安全性を確保することは重要な課題であり、このための取り組みが積極的に行われてきました。

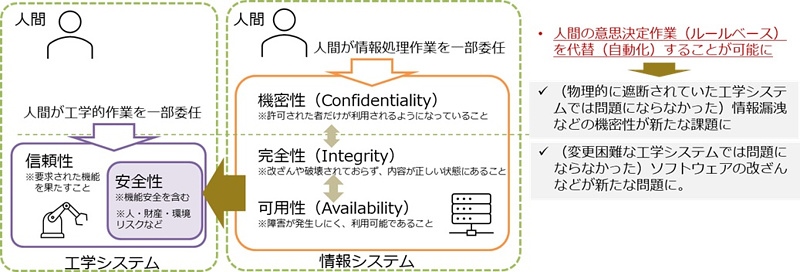

その上で、このような工学・機械系のシステムは、IT 技術の発展により、現代では、情報システムによって制御されるようになってきています。このため、工学・機械系システムの信頼性の確保にあたっては、その情報システムに係るアルゴリズムに係る信頼性の確保だけでなく、いわゆる情報セキュリティとして、可用性(Availability)、完全性(Integrity)、機密性(Confidentiality)の視点が課題になります。すなわち、情報システムの導入により、制御・自動化が進み、人間の意思決定機能を一部代替することが可能となる一方、情報漏洩を含めた機密性、ソフトウェアの改ざんなどの完全性の確保が新たな課題になってきました(図13参照)。

さらに、情報システムがインターネットと接続され、ネットワーク化したことにより、より利便性が向上しましたが、一方で、外部からの攻撃を含むサイバーセキュリティへの対応が大きな課題になってきています。

図13:工学システムの信頼性と情報システムのセキュリティ

(2) AI システムにおける信頼性とセキュリティの確保

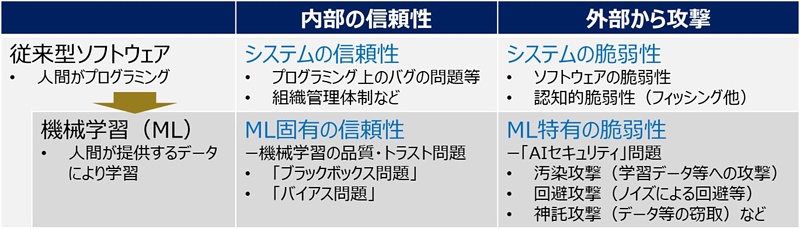

その上で、その情報システムにおいて AI 技術を導入する場合には、データを通じて学習するという AI 技術特有の問題に対応した信頼性の確保が最も重要な課題になります(図1 4参照)。

その際、まずは、そのアルゴリズムの信頼性(品質)が重要な課題になります。すなわち、これまでの入力に対して出力が明確なルールベースのソフトウェアと比較して、機械学習に よる AI アルゴリズムにはブラックボックス問題が存在し、入力に対して期待する出力が確実になされるか不明確という特徴があります。このため、AI システムの導入にあたっては、その信頼性(品質)確保のための取り組みが必要となります。このような中、現在、産総研 や AI プロダクト品質保証コンソーシアム(英⽂名:Consortium of Quality Assurance for Artificial-Intelligence-based products and services, 略称:QA4AI コンソーシアム)などが作成している機械学習に係る品質管理ガイドラインなどを参考にした信頼性(品質)向上に係る取り組みが進められています。

また、特に外部からの攻撃という観点から見た場合には、AI 技術自体に係る脆弱性という面も指摘されています。具体的には、汚染(ポイズニング)攻撃や、回避攻撃、神託攻撃などの様々手法の可能性が指摘されています。この AI システムに係るセキュリティ攻撃やその対処方法については、まだ研究段階という側面もありますが、このような問題への関心の高まりを受け、世界各国の連携による「セキュア AI システム開発ガイドライン(Guidelines for secure AI system development)、2023年11月、:日本のほかG7各国を含む計18か国の機関が共同署名」なども発表されているので、このような動きも考慮した開発が期待されます。

図14:AI システムの信頼性とサイバーセキュリティ

(3) 重要な AI システムによる自動化に係る信頼性・安全性の確保

このように工学・情報システムの中に高度な AI 技術を組み込むことにより、認識、最適化、行動の一連の作業の自動化を進め、これまでの人間が判断してきた機能の多くを代替することが可能となり、これにより、大幅な業務の効率化が可能となります。

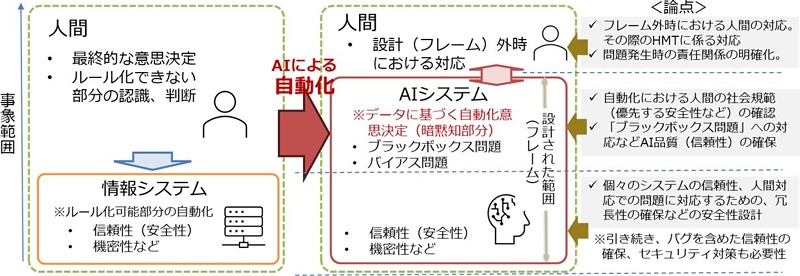

ただし、例えば、自動運転や医療診断など、特に現実世界において人の生命に関わるような重要なシステムにおいて自動化する場合には、当然ながら、高いレベルでの信頼性・安全性が求められることになります。その際、運転手、医者を含め、人間は、一般的には、あらゆる環境に対して柔軟に対応できるのに対して、AI システムは、そもそも一定の設計枠組

(フレーム)において、期待される出力・回答できるよう作成されたシステムにしか過ぎないことに留意することが必要になります。

このような観点から、人間と AI システムの両方を含めた全体で見た場合、二つの視点での信頼性の確保が重要になります(図15参照)。まずは、その枠組(フレーム)内での信頼性確保です。この場合、原則として、(2)に記載した通り、機械学習の信頼性確保(品質向上)に係る取り組みが必要になりますが、それに加えて、例えば、一部のシステムが機能しない場合などを想定したシステムの多重化などの追加の取り組みが必要となります。また、その AI 技術の設計枠組(フレーム)の範囲を拡大するにつれ、より複雑な、人間と同様の社会規範を組み込むことが課題になります。例えば、自動運転の場合、単に道路の状況や交通法規に従って走行するだけでなく、交通警官の身振りでの指示があった場合に対応できるようにするとした場合には、更に多大な学習が必要となります。

そのような中、世の中の全ての事象に対して学習することは困難であることを踏まえつつ、AI システムにおいては一定の設計枠組を設定することになりますが、次に、枠(フレーム)外の事象が生じた場合における信頼性の確保が課題になります。その際、一般的には、人間による管理(Human Oversight)が必要になりますが、その場合には、設計枠組みの枠内から枠外へ移行する場合の円滑化も含めて、人間‐機械チーミング(Human-Machine Teaming; HMT)の在り方を検討することが課題になります。なお、その際、人間の意思決定自体も必ずしも完全ではなく、間違った判断を行う可能性もあることに留意する必要が生じます。

図15:信頼性(安全)に係る重要 AI システムによる自動化と課題

これまでのコラム

(第1回)イノベーションのためのガバナンス

(第2回)社会規範・倫理と技術による社会的リスク

(第3回)社会的リスクに対応する制度としてのガバナンス

(第4回)AI 技術の利用がもたらす社会的リスク

筆者紹介 市川 類(いちかわ たぐい)

東京科学大学 データサイエンス・AI全学教育機構 特任教授

一橋大学 イノベーション研究センター 特任教授

筆者紹介の詳細は、第1回をご参照ください。