第3回 AIシステムにおける広義の品質・トラスト (1)

前回は機械学習型のAIシステムにおいて最も重要な品質特性である予測性能についてまとめました。予測性能は「答えの正しさ」に注目したものですが、AIシステムに対してはより広い観点の品質を考える必要があります。

ソフトウェア工学分野では、信頼性、保守性、セキュリティなど品質の異なる観点を品質特性と呼びます。AIシステムにおいては、自動運転や雇用、教育など人間・社会に大きな影響を与える応用を考えることが多くあります。このことから、品質よりも広い言葉として、「信頼できる」ということを指す「トラスト」という語がしばしば用いられます。トラストを考える場合でも結局、人種や性別に関する不当な振る舞いをしない公平性など、特性・観点を明確にし、具体的な実現技術や評価指標を検討していくことになります。

本コラムでは、今回(第3回)と次回(第4回)の2回にかけて、AIシステムならではの品質やトラストの特性について紹介します。

説明可能性

AIシステムを活用する際に、出力がどのような規則や根拠で得られたのかの説明が重要となる場合があります。代表的な状況としては、医療診断や与信判断など、人間がAIの判断を踏まえて最終的な意志決定を行う状況があります。このような状況で、AIが「ガンだと判定した」「ローンは許可すべきでない」といった結果のみを出力すると、AIの出力が妥当なのか、どう自身の判断に反映すべきかを人間が判断できません。

このため、「画像のこの部分を見てガンだと判断した」「年収を見てローンは許可できないと判断した」といった説明が重要となります。このような説明がなされる度合いを表す品質特性を、説明可能性や解釈性と呼びます。2016年前後にアメリカにおいて説明可能なAI、XAI (eXplainable AI)というビジョンが掲げられ、以降盛んに考え方や技術が追及されました。

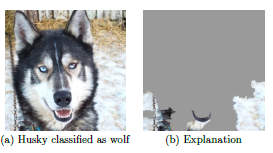

前述の例では「入力のどの部分が出力に影響するか」という説明の形式を挙げました。このような説明を出力する技術として、LIMEやGrad-CAMといったツールがよく知られています。図1は、LIMEによる出力の有名な例です。左の画像に写った動物の分類タスクにおいて、本来ハスキー犬が正解のところAIがオオカミと答えたという状況です。この場合における説明の出力が右側の画像で、入力画像内の雪が判断に影響したとわかります。

図1 Ribeiroら、”Why Should I Trust You?”: Explaining the Predictions of Any Classifier より引用

「雪があるからオオカミだろう」という判断は、当たるときも多いかもしれませんが、オオカミのみの特徴とは言えません。このような説明があれば、利用者は今回の出力を信頼しないという判断できます。また、AIの開発者・提供者としても、例えば他の動物が雪の中にいる画像を訓練データに加えるなど、改善点について検討することができます。

このように、一つ一つの出力に対して、根拠を示すアプローチを「局所的な説明」と呼びます。入力内でどの部分が影響したか、という説明形式のほかにも、訓練データ内のどのデータが出力に影響したかを説明する技術(Influential Function)などもあります。

これに対して、AIが様々な入力に対しどのような規則性を用いて判断を行っているかをとらえようとするアプローチを「大域的な説明」と呼びます。例えば、「年収が400万円以上で年齢が30歳以下ならローン許可」といった条件分岐(決定木やルールと呼ばれる形式)や一次関数など、人間が解釈できる計算構造でAIの計算規則を近似することになります。ただし、AIが本来非常に複雑な計算をしているところ、非常に単純化しないと人間は解釈できないので、「年収が100万円以下だと許可しない」といった、AIが実際に行う複雑計算とはかけ離れた、単純過ぎ自明な計算規則が導かれてしまうこともあるかもしれません。

以上のような説明の技術は、ある程度確立され普及しています。医療診断など分野によっては局所的な説明をAIシステムの出力として含めることが重要となっています。一方で、説明はあくまで近似であり、説明機能をシステムに埋め込みその信頼性・価値を評価する工数もかかるでしょう。図1の「雪を見てオオカミ」の例はわかりやすいのですが、実際は、注目領域は適切だが間違えることも多くあります。そもそも、「(人間と同じ根拠ではないとしても)高精度に正解が出せる」だけでも十分な価値があることもあります。いつでもとりあえず説明が必要ということではないでしょう。

追跡可能性・透明性

AIシステムに関しては、追跡可能性(トレーサビリティ)や透明性といった特性もよく論じられます。説明可能性という語はあくまで、出力の規則・根拠に関する観点で用いられます。「AIシステムがなぜ信頼できるのか」という広い問いに対しては、追跡可能性や透明性といったより広い特性で論じられます。

例えばどのような訓練データが用いられたか公開することで、適切にAIが構築されたことが利用者からも確認できるようにするといったことです。「出所を確認できる」という意識では、追跡可能性(トレーサビリティ)という語が用いられますが、「構築の過程や仕組みが確認できる」という意識では、「透明性」という語が用いられます。

機械システムでの位置づけ

機械システム分野で活用されるAIシステムは多様で、一概に断言することはできませんが、組織内部での不良品検出、異常検知、機器制御などに用いられることが多いかもしれません。その場合、直接社会に対して安心・納得してもらうという、トラストを示すということではないかもしれませんが、様々な立場のステークホルダーに安心・納得してもらうということは必要不可欠でしょう。

次回も引き続き、機械学習型AIシステムならではの品質・トラストの特性について紹介していきます。

これまでのコラム

第1回 機械学習技術によるAIの産業における活用

第2回 AIシステムにおける予測性能とデータ品質

筆者紹介 石川 冬樹(いしかわ ふゆき)

石川 冬樹 国立情報学研究所 アーキテクチャ科学研究系 准教授

筆者紹介の詳細は、第1回をご参照ください。