近年の AI(Artificial Intelligence、人工知能)技術への関心の高まりと相まって、その利用による社会的リスクについても関心が高まり、そのガバナンスの必要性が指摘されています。

計 10 回にわたる本コラムでは、このような AI 技術による社会的リスクとそのガバナンスを巡る全体像について俯瞰していきます。

本連載の筆者は、市川類 東京科学大学 データサイエンス・AI全学教育機構 特任教授 / 一橋大学 イノベーション研究センター 特任教授 です。

©2024 Tagui Ichikawa(本コンテンツの著作権は、市川 類 様に帰属します)

第6回 プライバシーに係る社会的リスク

前回のコラムでは、AI システムに係る信頼性・安全性に係る社会的リスクの概観についてお話をしました。

今回のコラムでは、AI 技術がもたらす、個人に係るプライバシーや人格権の保護に係る社会的リスクについてお話します。

(1) プライバシーに係る技術と制度の共進化

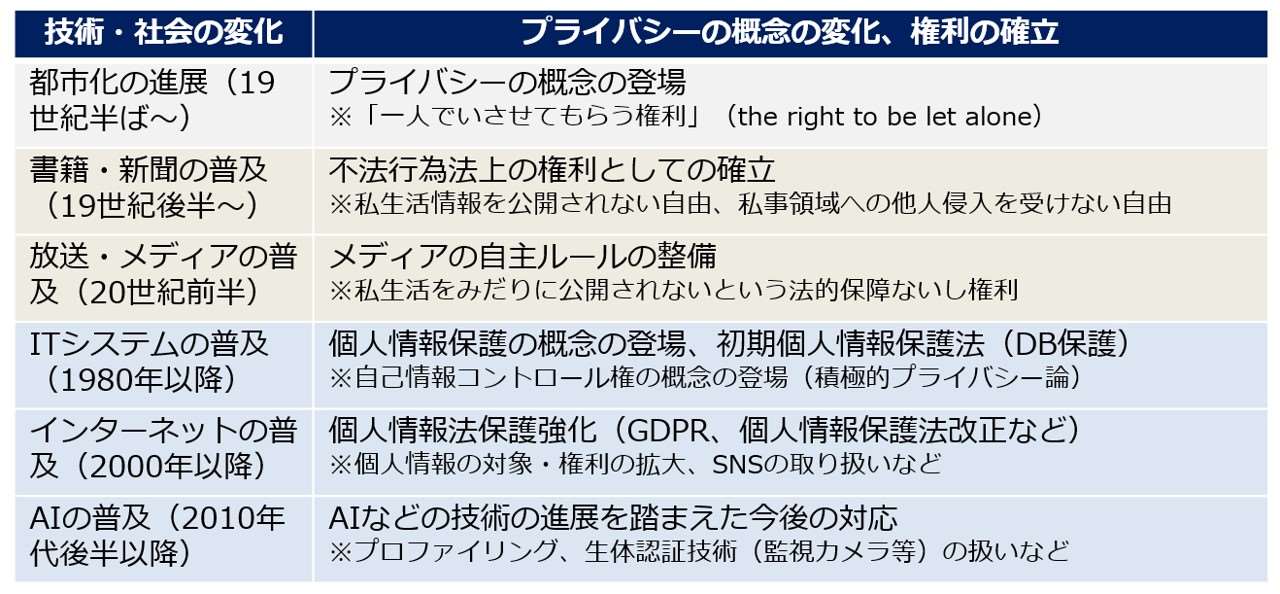

プライバシーの一部として個人情報の保護は、現在では法制化もなされ、遵守しなければいけないルールとして位置づけられています。しかしながら、歴史的にみると、プライバシーの概念は、情報通信関連技術の進展の中で登場し、その技術の進展とともにルールとして整備されるなど、「技術と制度の共進化」が進んできた分野の一つです(図16参照)。

もともとプライバシーの概念の歴史は比較的浅く、19 世紀末期になって、都市化が進展し、書籍や新聞などが普及する中で、「一人でいさせてもらう権利」として始めて概念化されたものです。その後、20 世紀後半の情報システムの発展・普及に伴い、OECD 原則が発表されるなど、個人情報の保護の重要性が指摘されるようになりました。そのような中、個人情報保護法が法制化されるとともに、現代では、人権の一つとして「自己情報決定権」を確保すべきとの法学的議論がなされるようになってきています。なお、個人情報を収集・利用する際には、利用目的に関して本人への通知又は同意を得ることが OECD 原則に掲げられ、世界的な標準になっています。

図16:プライバシーの歴史の経緯

このような流れの中で、今回、AI 技術が登場してきたことになります。その際、もちろん、AI 技術の開発・利用にあたっては、まずは、例えば、個人データを AI の学習や、AI を利用して生成した個人に係るデータの利用などにおいて、個人情報保護法などの法制に沿ったものとすることが必要となります。

その上で、今後、AI 技術によってプライバシー関連の新たな社会的リスクが生じ、その結果、法制度も変化していく可能性もあるとみることもできるでしょう。なお、現在、個人情報保護委員会は、AI 技術の登場による影響を含めた個人情報保護法の見直しに向けた検討を進めています。

(2) AI システムによるプライバシーに係る新たな社会的リスク

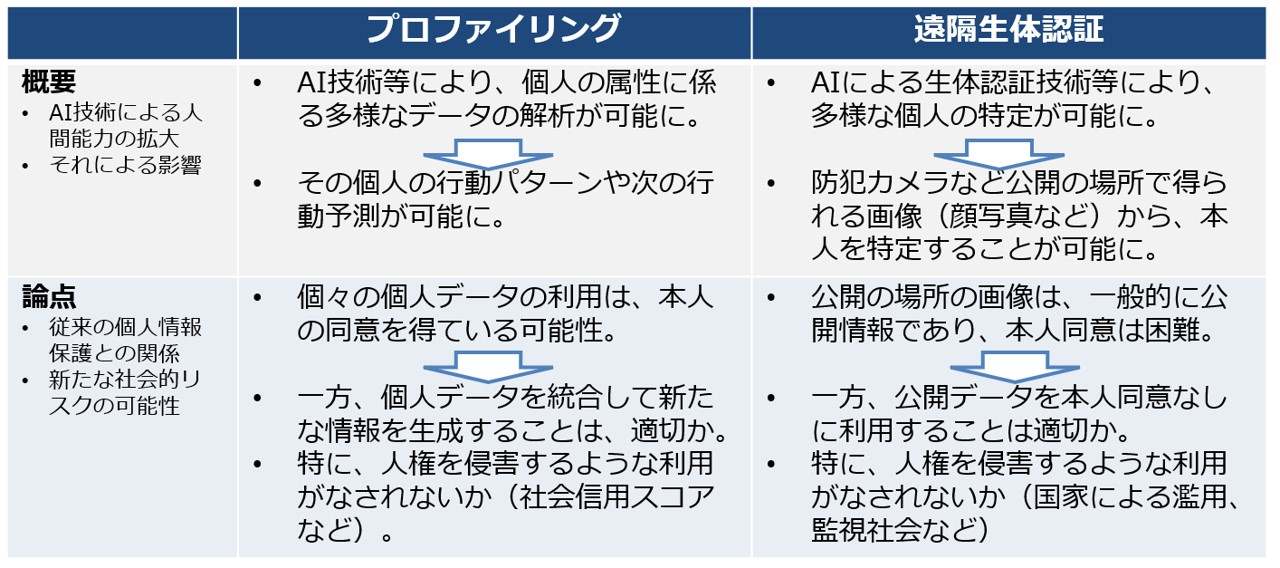

実際に、海外の動向などを踏まえると、プライバシーの観点からみて、現在の個人情報保護法では必ずしも十分明確化されず、あるいは対応できないような社会的リスクの事例がいくつか生じてきています(図17参照)。

例えば、まず一つは、プロファイリングやそれを利用した社会信用スコアの作成などの問題があげられます。プロファイリングとは、個人に係る複数・多数の情報を統合し、AI 技術を通じて解析することにより、個人の人格や個性などの特徴を明らかにする手法のことです。本来、個人情報保護法では、個々の情報の利用については、原則本人への通知・同意を得て利用することとされていますが、統合されて人格などが知られることは想定されていない可能性があります。また、このような人格や個性などに係る情報は、社会信用スコアを含め、場合によっては、本人の人権を侵害する不適切な利用がなされる可能性が生じます。

また、もう一つの事例は、特に生体認証の問題があげられます。現在は AI 技術を利用した顔認証などの生体認証技術により、個人を特定することが可能になっています。その際、従来は、特に防犯カメラなど公開の場所で得られたデータに基づき、本人への通知・同意を得ることなく、個人を特定することが可能になります。この問題は、防犯などの社会の安全性の問題とプライバシー・人権の保護のバランスに関わる問題として活発な議論がなされています。

いずれの場合についても、欧州などでは新たな規制の対象として明確化されつつあります。日本でも、一部議論が開始されていますが、いずれにせよ、このような利用を行う AI システムを構築する場合には、社会的リスクの一つとなりうるものと認識することが必要となります。

図17:AI によるプライバシーに係る新たな社会的リスク(例)

(3) 生成 AI の利用によるプライバシー・人格権等に係る社会的リスク

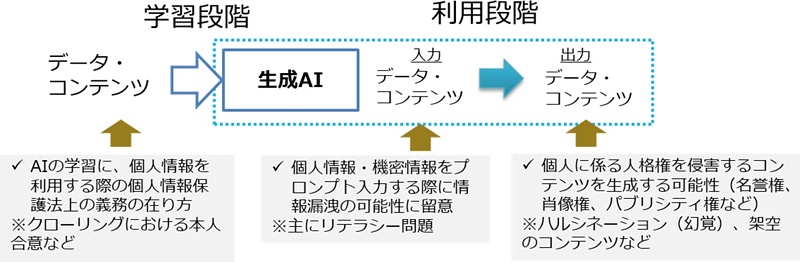

また、生成 AI においても、同様に、個人情報保護法などの法制に沿った取り組みが必要になります。特に、個人情報や機密情報をプロンプトとして入力する場合には、それらの一部が公開される可能性があることに留意することが必要となります。これは、利用者のリテラシーの問題であるともいえます。

その上で、生成 AI により個人に関わるコンテンツを生成した場合、その内容が不正確であれば、場合によって、個人の人格権の問題に関わるリスクが生じる可能性があることに留意することが必要になります。例えば、生成 AI においては、幻覚(ハルシネーション)と呼ばれるような「嘘」を回答する可能性がありますが、個人に係る「嘘」を生成した場合には、場合によっては、個人情報保護法だけでなく、個人の名誉権、肖像権、パブリシティ権などの人格権を損なうなどの社会的リスクが生じる可能性があります(図18参照)。

図18:生成 AI によるプライバシー・人格権等の課題(論点)

これまでのコラム

(第1回)イノベーションのためのガバナンス

(第2回)社会規範・倫理と技術による社会的リスク

(第3回)社会的リスクに対応する制度としてのガバナンス

(第4回)AI 技術の利用がもたらす社会的リスク

(第5回)信頼性・安全性に係る社会的リスク

筆者紹介 市川 類(いちかわ たぐい)

東京科学大学 データサイエンス・AI全学教育機構 特任教授

一橋大学 イノベーション研究センター 特任教授

筆者紹介の詳細は、第1回をご参照ください。