近年の AI(Artificial Intelligence、人工知能)技術への関心の高まりと相まって、その利用による社会的リスクについても関心が高まり、そのガバナンスの必要性が指摘されています。

計 10 回にわたる本コラムでは、このような AI 技術による社会的リスクとそのガバナンスを巡る全体像について俯瞰していきます。

本連載の筆者は、市川類 東京科学大学 データサイエンス・AI全学教育機構 特任教授 / 一橋大学 イノベーション研究センター 特任教授 です。

©2024 Tagui Ichikawa(本コンテンツの著作権は、市川 類 様に帰属します)

第7回 公平性・妥当性に係る社会的リスク

前回は、AI システムに係るプライバシーの観点からの個人情報の利用に係る社会的リスクについてお話しました。

今回は、一部はその個人情報の利用に関係しますが、特にバイアス(偏り)という視点から見た、公平性、社会的妥当性に係る社会的リスクについてお話します。

(1) AI が学習するデータのバイアスと公平性に係る社会規範

個人に対する公平性・非差別性の確保は、人権問題に係る社会規範の一つであると位置づけられます。日本でも、憲法において、全ての国民は、人種、信条、性別、社会的身分等において差別されないと規定し、これを踏まえて、教育、雇用、司法などの各分野において、個人に対する公平性に配慮した意思決定を求める仕組みがそれぞれ整備されています。

このような意思決定は、これまで人間が担ってきましたが、AI 技術の登場により、AI システムが人間に代替して行うことが可能になってきています。ただし、その AI システムによる意思決定においては、過去の多くの個人情報をその学習に利用することになりますが、その際、データバイアスによる公平性に係る社会的リスクが大きな課題となります。

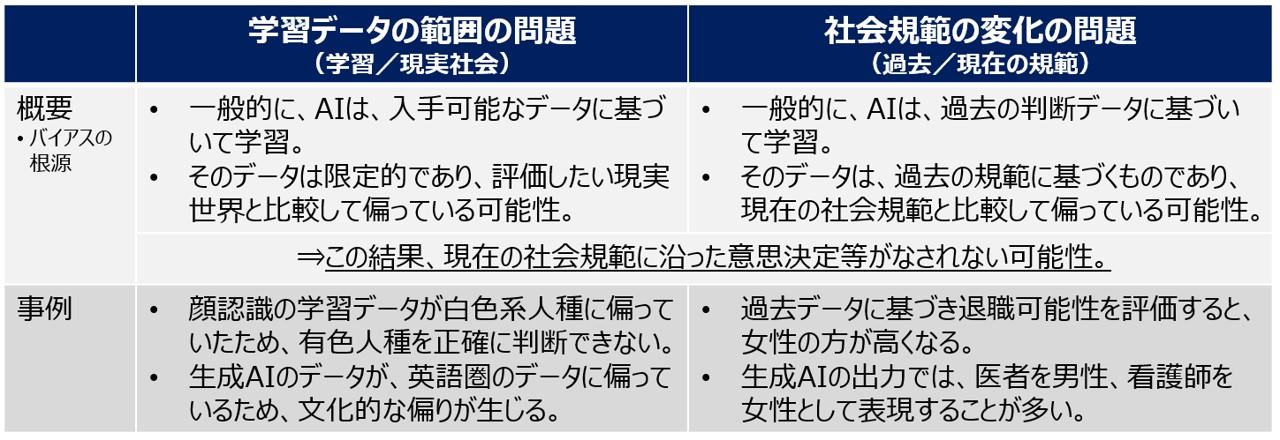

特に学習するデータのバイアス(偏り)については、二つの視点があります(図19参照)。一つは、学習するデータの対象範囲が、システムに組み込むべき社会全体(世界)の対象範囲と比較して偏っているという視点です。例えば、学習するデータが男性に偏っているため、女性を適切に評価できないという可能性があります。 もう一つは、そもそもの学習する過去のデータの基となる社会規範が、現在の社会規範として共有される価値と異なってきている視点です。例えば、過去の女性の離職率の高さの社会的背景を考えずに、そのまま現在に応用するような場合です。この両方の視点において、 AI システムの利用においては、個人の意思決定に係る公平性に関して社会的リスクが生じる可能性があります。

図19:現実社会・規範からみた学習データの二つのバイアス

(2) 重要な AI システムによる意思決定に係る公平性の確保

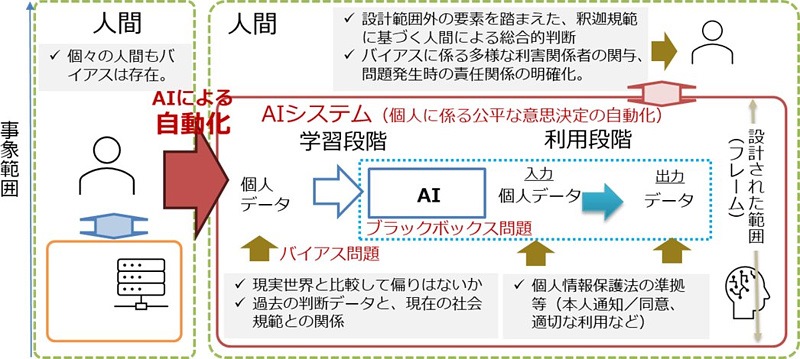

このようなデータバイアスが社会的リスクになるのは、特に、個人の人生における重要な意思決定に関して、AI システムによる自動化を行う場合が相当します。例えば、教育、雇用などに係る意思決定に加え、裁判を含む政府による意思決定などの場合です。また、その際、特に、性別、人種など人権問題・社会規範の観点から公平性が求められる視点でのバイアスが論点になります。

具体的には、海外などでは、雇用の場面において、女性に対して差別的な意思決定を行っ たり、再犯可能性を評価する際に、有色人種に対して差別的な評価を行ったりする場合などが指摘されています。なお、このような問題は、個人情報を利用して意思決定を行うものであり、見方によっては、個人情報保護法における不適切な利用に相当する可能性もあります。

したがって、このような個人に係る重要な意思決定を行う AI システムを構築する場合には、学習するデータの範囲に十分注意するとともに、現在の社会規範に照らした意思決定がなされる仕組みを構築することが重要になります。そのためには、やはり、最終的には、人間による監督(Human Oversight)が必要との議論もあります。一方、そもそも個々の人間による意思決定においても、少なからず社会規範に対してバイアスが存在することを踏まえると、多様な利害関係者の見方を意思決定の中に組み込むことが重要であると指摘されています(図20参照)。

図20:重要 AI システムによる意思決定の自動化と公平性に係る課題

(3) 生成 AI システムに係るバイアス問題と社会における妥当性

生成 AI においても、学習するデータ・コンテンツによるバイアスの問題が指摘されています。ただし、生成 AI の場合は、意思決定というよりは、コンテンツに係る表現上のバイアスの問題が中心になります。

具体的には、生成 AI による回答の内容に関して、例えばパイロットは男性として、また、看護師は女性として表現するなどジェンダー平等の視点から問題が指摘されたり、生成 AIの種類によって、保守的、リベラル的などの政治的な思考が異なるなどといった指摘がなされたりしています。また、海外製の生成 AI では、英語圏の情報・思想に偏っているとの指摘もあります。

このような生成 AI に係るバイアスは、図19に示したとおり、学習するデータ・コンテンツの偏りや、過去と現在の社会規範の差異によって生じます。ただし、それに加えて、社会的に適切な回答を行うために行われている、人間のフィードバックによる強化学習(RLHF; Reinforcement Learning from Human Feedback)の段階においても、偏りが形成されることが指摘されています。

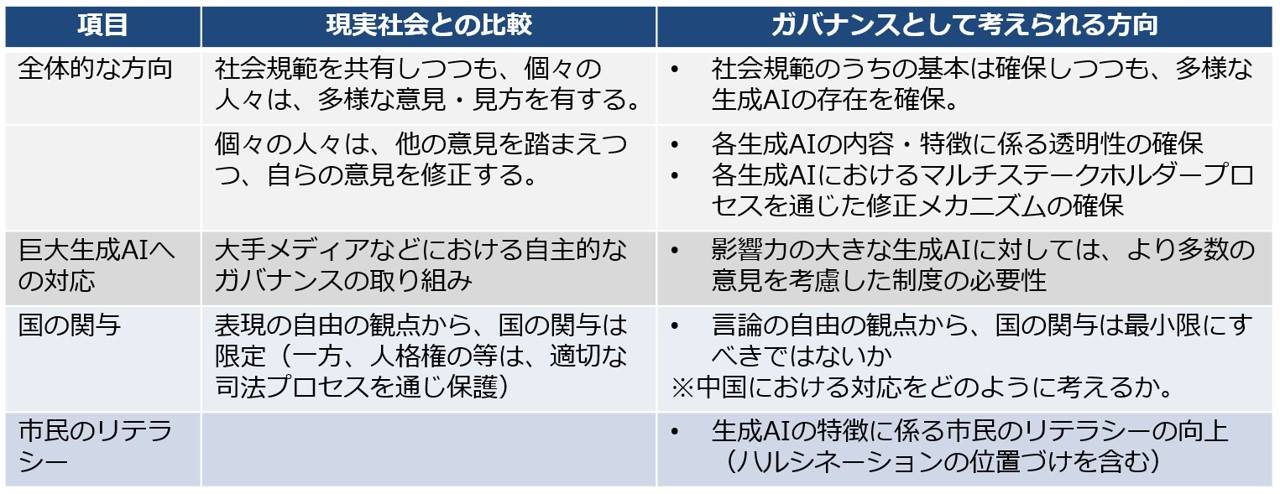

これらの生成 AI におけるバイアスは、個人に係る公平性というよりは、むしろ社会的な妥当性に相当するものであり、特に影響力が大きな生成 AI に関しては、その将来的な社会的影響が懸念されています。ただし、このような表現・コンテンツに係るバイアスに関しては、個々の人間においても異なる個性を有していることを踏まえると、社会規範において妥当とされる範囲内において、表現の自由の観点から一定の多様性は容認すべきではないか、また、特に国が積極的に関与すべきものではないとの見方もあります。例えば、中国では、 生成 AI に対する規制を導入し、その表現に「社会主義核心価値観」を反映することが求められていますが、民主主義国家ではこのような規制を行うことは認められないものと考えられます(図21参照)。

図21:生成 AI の社会的妥当性に係る論点(現実社会との比較)

これまでのコラム

(第1回)イノベーションのためのガバナンス

(第2回)社会規範・倫理と技術による社会的リスク

(第3回)社会的リスクに対応する制度としてのガバナンス

(第4回)AI 技術の利用がもたらす社会的リスク

(第5回)信頼性・安全性に係る社会的リスク

(第6回)プライバシーに係る社会的リスク

筆者紹介 市川 類(いちかわ たぐい)

東京科学大学 データサイエンス・AI全学教育機構 特任教授

一橋大学 イノベーション研究センター 特任教授

筆者紹介の詳細は、第1回をご参照ください。