近年の AI(Artificial Intelligence、人工知能)技術への関心の高まりと相まって、その利用による社会的リスクについても関心が高まり、そのガバナンスの必要性が指摘されています。

計 10 回にわたる本コラムでは、このような AI 技術による社会的リスクとそのガバナンスを巡る全体像について俯瞰してきましたが、今回が最終回となります。

本連載の筆者は、市川類 東京科学大学 データサイエンス・AI全学教育機構 特任教授 / 一橋大学 イノベーション研究センター 特任教授 です。

©2024 Tagui Ichikawa(本コンテンツの著作権は、市川 類 様に帰属します)

第10回 AI に係るイノベーションとガバナンスの一体的取り組み

前回のコラムにおいては、世界における AI ガバナンス政策の動向についてお話しました。

今回は、本コラムの最終回ということで、日本における AI ガバナンス政策動向を踏まえた上で、企業における今後の AI ガバナンスに係る取り組みの方向についてお話します。

(1) 日本における AI 規制・ガバナンス政策を巡る最近の動向

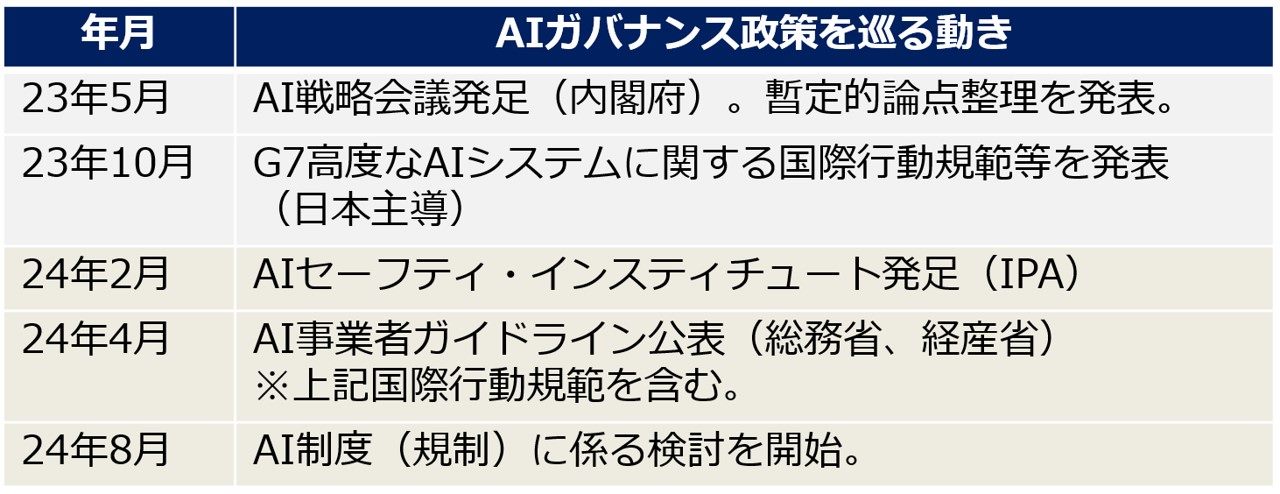

前回のコラムでお話したとおり、これまで日本の AI ガバナンス政策は、概ね、自主ガイドラインの発行など比較的弱い規制を志向していることが特徴でした。

そのような中、生成 AI ブームと AI ガバナンスに係る世界的な関心の高まりを踏まえて、日本政府は、まず、国際的には、G7 の議長国という立場を生かし、広島 AI プロセスを立ち上げ、その後G7 各国との調整を主導したことが特徴です。その成果として、2023 年 10 月には、高度な AI システムに係る国際行動規範が発表されましたが、この国際行動規範は、世界における AI ガバナンス政策における相互運用可能性を確保するためにも重要な位置づけになります。

また、国内では、これまでの総務省や経済産業省の自主ガイドラインに関して、上記国際行動規範やそれ以外の生成 AI への対応を含める形で、統合・大幅見直しを行い、2024 年 4 月に 「AI 事業者ガイドライン(総務省、経済産業省)」として発表しています。

一方、2023 年秋以降、欧米では、生成 AI(基盤モデル)などの高度な AI システムを対 象に、政府による規制枠組みを設けつつ、その中で、上記行動規範等を踏まえつつ事業者が自主的に対策に取り組むという「共同規制」的なアプローチの検討が進みつつあります。このような状況を踏まえ、日本においても、2024 年 8 月より、改めて AI 制度の在り方に係る検討が開始されています(図28参照)。

図28:最近の日本における AI ガバナンス政策を巡る動き

(2) 企業におけるイノベーションとガバナンスの一体的取り組みの必要性

第一回のコラムで説明したとおり、企業において、社会に新たな価値を提供すべく、イノベーションを進めていくためには、その社会での受容が前提となり、そのためには社会的リスクを管理するためのガバナンスとの両立に取り組むことが必要になります。

その際、もちろん、まずは、上述のような世界や国内における政府による AI ガバナンス・規制動向に対応する必要があります。特に、今後とも、AI 技術が急速に進展していく中で、これらの動向も引き続き急速に変化していくことが想定されます。そのため、企業においては、このような動きを踏まえて迅速に対応できる体制を構築することが求められます。

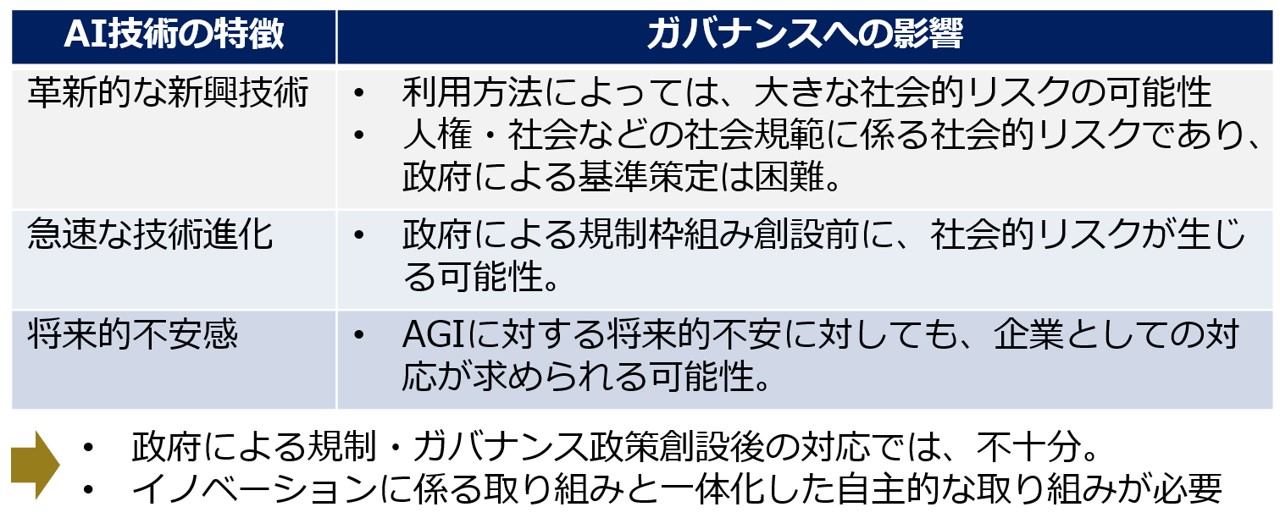

その上で、企業においては、このような政府や法制面での動きに対して単に受け身的に対応するだけではなく、先んじて AI ガバナンスに自ら取り組むことにより、「イノベーションとガバナンスの一体的取り組み」を実現することが期待されます。これは、以下の理由によるものです(図29参照)。

1. AI 技術は、革新的な技術であり、今後、大きな社会的リスクを引き起こす可能性があるとともに、その社会リスクとしては、従来の安全や環境などとは異なり、政府による明確な基準が策定されずに、最終的に企業の自主的な取り組みが求められる可能性があること。

2. AI 技術が急速に進化する一方、政府における迅速な対応が見込まれないことから、規制がなされる前に社会的リスクが拡大する可能性があり、企業としては、長期的な観点からこれらに対して事前に対応を検討する必要があること。

3. AI 技術の特徴として、単に社会的リスクだけでは、人々が共有する将来的な不安にも対応すること必要であり、特に世界的なビジネス展開には必須になること。

このようなイノベーションとガバナンスの一体的取り組みは、「責任ある AI」に係る取り組みとしても位置づけられます。ただし、その際、その両立を図ることが前提ですので、リスクを過大に評価することによってイノベーションに向けた前向きな取り組みを阻害するなどの過剰な規制・自粛にならないよう留意することが必要になります。

図29:AI におけるガバナンスとの一体的取り組みの必要性

(3) 社内における AI ガバナンス体制の整備に求められる方向

企業においてこのような AI ガバナンスに取り組むためには、まずは、そのための社内体制を整備していくことが課題になります。その際、AI システムは情報システムの一部であり、一般的には、これまで情報システムに係るリスク対応として取り組まれている情報セキュリティ、個人情報保護、著作権保護を含む法務関係などの体制と連携しながら、取り組んでいくことが合理的であると考えられます。

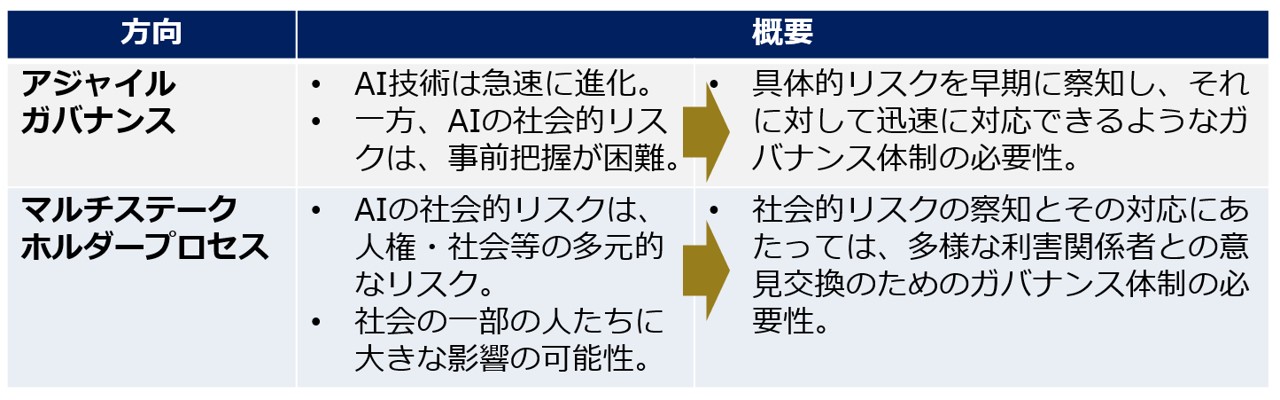

一方で、AI システムに係る社会的リスクの性質を踏まえると、社内での AI ガバナンス体制の構築にあたっては、以下の2点が重要になります(図30参照)。

1. アジャイルガバナンス: AI 技術は、今後とも、急速に進展していくことを踏まえると、企業自ら潜在的な社会的リスクを早期に把握し、迅速に対応を展開できる社内体制の整備が重要になります。

2. マルチステークホルダープロセス: AI 技術に係る社会的リスクは、安全性・環境問題のように、技術の専門家のみによって対応できるものではなく、当該社会的リスクに係る多様な文化・社会の意見の理解が必要になります。このため、このような多様な利害関係者(マルチステークホルダー)の意見を社内の意思決定プロセスへ組み込んでいくことが重要になります。

企業においては、これまで製品の開発を行い、それを市場に提供するに当たっては、事前にその安全性を確認する体制を整備するとともに、安全な製品の提供に取り組んできたと思います。今後、社会のデジタル化・AI 化が進展する中でAI 技術を活用していくには、AI 技術を巡る特徴を踏まえた AI ガバナンスに係る体制をあらかじめ整備し、AI を利用した安全安心なサービスを提供することが当然のこととして求められる世界がやってくるものと考えられます。

図30:AI ガバナンス体制に求められる2つの方向

これまでのコラム

(第1回)イノベーションのためのガバナンス

(第2回)社会規範・倫理と技術による社会的リスク

(第3回)社会的リスクに対応する制度としてのガバナンス

(第4回)AI 技術の利用がもたらす社会的リスク

(第5回)信頼性・安全性に係る社会的リスク

(第6回)プライバシーに係る社会的リスク

(第7回)公平性・妥当性に係る社会的リスク

(第8回)コンテンツ規範に係る社会的リスク

(第9回)AI に係る将来的な不安感と世界における AI ガバナンス政策の動向

筆者紹介 市川 類(いちかわ たぐい)

東京科学大学 データサイエンス・AI全学教育機構 特任教授

一橋大学 イノベーション研究センター 特任教授

筆者紹介の詳細は、第1回をご参照ください。